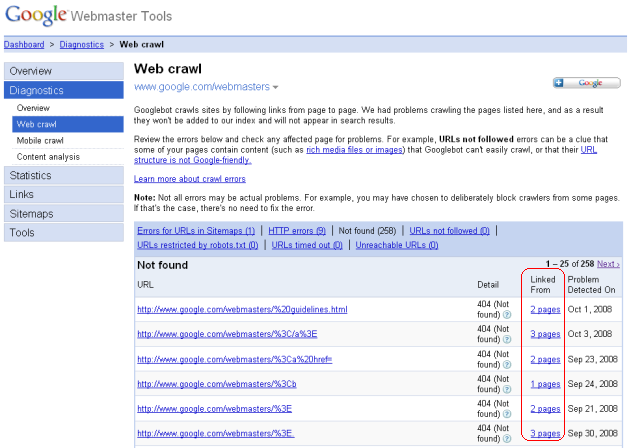

Les Google Webmaster Tools, interface pour webmasters du moteur de recherche, proposent depuis hier une nouvelle fonctionnalité avec la détection des liens internes et externes ("backlinks") pointant vers des pages n'existant plus sur votre site et générant un code 404. L'outil se trouve dans la rubrique "Diagnostics", option "Web crawl", lien "Not found"... Les pages non trouvées s'affichent alors et un lien intitulé "Linked From" vous liste les urls qui pointent par erreur sur ces pages...

Détecter les backlinks cassés avec GWT

vendredi 17 octobre 2008 à 15:09 Publié par -

Libellés : backlinks, gwt 0 commentaires

Website Grader

mercredi 15 octobre 2008 à 09:51 Publié par -

Site Grader est un outil Web qui analyse votre site Web en fonction de nombreux critères, pour obtenir de plus amples informations sur votre référencement : Google Page Rank: de nos jours, ce critère n'est pas pertinent que 1 ou 2 ans, sauf si il ya de liens sponsorisés ...

Google Page Rank: de nos jours, ce critère n'est pas pertinent que 1 ou 2 ans, sauf si il ya de liens sponsorisés ...

Structure de page Web : détection des tags analytique.

Domain name : qqs infos a propos du nom de domaine

Heading summary : analyze du header et detection des h1, h2, h3 …

Pictures information : outil pour détecter les photos de votre hoempage et de voir si l'attribut alt est renseigné.

Nbre des pages indexées sous Google

Google Crawl date : Dernière date du crawl de Google

RSS: détection RSS et de l'information pour les abonnés Bloglines .

Nbre des backlinks

Technorati ranking

Del.icio.us bookmarks : Combien de personnes ont bookmarké votre site

Readability level : : Analyse (je ne sais pas comment) du niveau d'éducation necessaire pour lire et comprendre les pages de votre site

Digg.com submission summary : voir si qq a soumit des articles de votre site sur digg

http://www.websitegrader.com/

Exemple de rapport : http://www.websitegrader.com/wsgid/1561198/default.aspx

Libellés : Site Grader 0 commentaires

[Google] Google Audio Indexing : GAudi

à 09:48 Publié par -

Google Audio Indexing est en fait une nouvelle technologie de Google qui permet aux utilisateurs d'effectuer de meilleures recherches vidéos et regarder des vidéos YouTube à partir de divers canaux.

C'est une technologie qui permet de trouver dans un discours un mot que la personne a dite (puis plus tard dans d'autres types de vidéos). Et permet à l'utilisateur d'accéder directement à la partie de la vidéo où ces mots sont prononcés. Google réalise ici un grand pas dans les moteurs de recherche.

Pour le moment les tests sont effectués sur la prochaine élection présidentielle où est basé Google. Mais ils ont déjà prévu d'améliorer le service pour le proposer ensuite à d'autres vidéos.

Lien officiel :

http://labs.google.com/gaudi

Aide de GAudi :

http://labs.google.com/gaudi/static/faq.html

Libellés : GAudi, google audio, Google Audio Indexing 0 commentaires

Optimiser la proéminence des mots-clés

mardi 14 octobre 2008 à 08:50 Publié par -

La proéminence d'un mot est une mesure de sa distance relative par rapport au début du texte. Elle s'exprime sous la forme d'un pourcentage qui est d'autant plus élevé que le mot est placé au début du texte. Il semble bien que la proéminence fasse partie des critères d'analyse on page utilisés par Google (et par d'autres moteurs). Il est donc important d'essayer dans la mesure du possible de positionner les mots les plus stratégiques d'une page plutôt vers le début.

L'une des techniques les plus importante est la place du texte dans le code. Il faut veiller à ce que le bloc de contenu principal soit placé peu après la balise même s'il s'affiche visuellement après d'autres blocs (menus de navigation, marges, etc.).

Essayez de faire du premier paragraphe un résumé de l'ensemble de l'article (de la page), ce qui vous permettra d'y glisser la plupart de vos mots stratégiques. Autre avantage : Google utilisera souvent ce premier paragraphe pour constituer le petit descriptif de 2 lignes (snippet) affiché dans la page de résultats.

Netlinking : Bon lien et techniques de linkbait

lundi 28 juillet 2008 à 11:41 Publié par -

Voici le résumé d'une interview de Matt Cutts sur les caractéristiques des bons liens, sur les techniques de linkbait et particulièrement de widgetbait, sur les liens réciproques et sur quelques autres aspects du link building.

Caractéristiques d'un lien efficace en référencement sur du long terme

* le lien est éditorial, intégré dans un contenu texte

* le lien n'a pas été demandé par celui qui l'a reçu : celui qui a fait le lien l'a fait volontairement car il estime que la page en question est intéressante, utile, amusante, etc.

* les liens issus d'une opération de linkbait peuvent être considérés bons à long terme.

Le widgetbait (un linkbait basé sur un widget)

En termes de référencement Google, un bon widgetbait :

* ne cache pas 36 liens dans le code,

* précise clairement les choses aux webmasters qui veulent l'intégrer sur leur site,

* les quelques liens sont tous dans la thématique du site qui a créé le widget,

* les liens pointent vers le site qui a créé le widget et pas des sites tiers

Les liens réciproques

Selon Matt CuttsLes les liens réciproques ne sont pas néfastes pour le référencement dans Google ? En effet, les liens réciproques ne sont pas pénalisés dans l'algorithme de Google car ils sont un phénomène naturel sur le web. Par contre ce qui n'est pas naturel, c'est qu'une trop grande partie du profil de liens du site (ou de la page) soit faite de liens réciproques. Il ne faut pas tomber dans l'excès (mais bien entendu il n'y a pas de chiffre officiel ou optimal sur le taux de liens réciproques à ne pas dépasser...).

Liens venant de sites à fort notoriété

C'est bien mais il ne faut surtout pas se concentrer uniquement sur ce type de liens. Un site dont la proportion de backlinks issus de site à très forte notoriété dépasse largement la moyenne peut être détecté par Google. Même si le PR (de la toolbar) ne veut plus dire grand chose, si on se base sur le PR des backlinks, il faut que leur répartition soit similaire à la répartition moyenne observée sur le web. Il ne faut pas recevoir l'essentiel des backlinks de pages à PR supérieur à 6 puisque ce n'est pas naturel...

Libellés : liens externes, link building, linkbait, stratégie liens, widgetbait 0 commentaires

Explication de l'effet Google “Sandbox”

mercredi 16 juillet 2008 à 14:09 Publié par -

Qu'est ce la Google “Sandbox”?

Le système Google Sandbox est une restriction très controversé que Google place sur les nouveaux sites Internet afin qu'ils n'aient pas un bon positionnement dans ses résultats de recherche pour un certain temps. Ce temps permettra à Google de déterminer si un site est légitime et digne de confiance ou de spam. Un site dis être dans la SandBox, est un site qui malgré de nombreux liens solides et un contenu unique et riche, ne réussira pas à à bien se positionner sur la requête qu'il vise à être classé.

Pourquoi certains sites ne sont pas "Sandboxés"?

Certains sites ont tout simplement de la chance d'éviter la "Sandbox" et certains tentent de se positionner dans une industrie que Google ne considère pas extrêmement compétitif.

Disons que vous avez un site offrant de l'information sur Baleine Blanche. Ce site serait pertinent et serait beaucoup moins sujet au spam par rapport à un site axé sur "Gagner de l'argent en ligne" !

Il convient de noter que même si un site est soumis à l'effet "Sandbox" , il peut encore assez bien positionner pour ce qui est appelé les résultats de longue traine.

Donc, je suis, comment puis-je sortir?

Malheureusement, il n'est pas un moyen sur de sortir de Google "Sandbox". Il y'a des théories qui suggèrent de placer votre site sur un sous-domaine d'un site créé, puis faire une redirection 301 à votre domaine une fois établi. L'idée est que les filtres de la SandBox ne sanctionnent pas les sous domaines si les domaines sont ok. Malheureusement aucune preuve n'existe pour montrer que c'est vrai ! De plus quelle société voudrait être un parasite sur une autre entreprise?

Alors combien de temps?

Bien qu'il n'existe pas de données librement disponibles sur la durée de l'effet de la SandBox que Google impose de nouveaux sites, il semble que ça varie d'un site à un autre.

Parfois, il semble qu'il est simplement basée sur l'humeur de Google !!

Toutefois, une chose qui est presque certaine, c'est que le temps passé dans la "Sandbox" est directement affecté par un facteur de confiance pour votre site (TrustRank). En effet, Google donne un certain degré de «confiance» à un site en fonction de différents facteurs. L'un d'entre eux étant l'âge de votre domaine. Ainsi un nouveau site sandboxé ayant un domaine âgé de 10 ans serait presque certainement en dehors de la Sandbox de Google avant un site dans des conditions similaires sur un domaine enregistrés récemment.

Donc, ne me reste plus qu'à attendre?

Oui et non. Oui vous devez attendre, mais non, vous pouvez vous rendre à votre travail sur les sites de confiance et d'autorité dans l'intervalle. Utilisez le temps dans le "Sandbox" pour créer un contenu de qualité et d'obtenir des liens pertinents de la part des sites d'autorités dans votre domaine d'activité. Utilisez ce moment pour vous assurer que les facteurs de référencement On Page sont impeccables de sorte que à la sortie de la SandBox votre site sera prêt.

Voici d'autres pistes :

- Essayer de prendre des liens des sites ayant comme domaines .edu, .gov, etc car ces sites sont généralement exemptés du filtre de la SandBox.

- Vous pouvez acheter un anciens domaine.

- Travaillez les requêtes non concurrentielles en attendant la sortie de SandBox.

- Comptez plus sur d'autres moyens que Google pour augmenter le trafic.

Et si je m'inscris aux services Google ?

Certains pensent que l'adhésion à adsense et l'utilisation de Google en matière de produits tels que AdWords et Google Checkout seront utiles. C'est tout simplement pas vrai.

Existe-t-il un Yahoo ou MSN Live "Sandbox"?

Actuellement, il n'est rien qui ressemble aux système de Google "Sandbox" appliqué à des sites dans Yahoo! ou MSN Live, mais récemment, il est devenu évident que Yahoo! a développé une mise «en attente» sur les nouveaux liens entrants avant de leur permet d'avoir un effet mesurable sur le positionnement. Ce temps varie en fonction de l'autorité et la permanence des liens entrants.

Google Analytics installé sur 1/3 des 500 plus gros sites web

vendredi 11 juillet 2008 à 16:21 Publié par -

Selon Pingdom, l'outil de mesure d'audience Google Analytics serait installé sur 1/3 des 500 plus gros sites web mondiaux.

Le point de départ de cette étude est que chez Pingdom ils utilisent Google Analytics, par curiosité ils voulaient savoir combien de gros sites utilisaient l'outil de statistique de google.

Ils ont mis les Top 500 sites web d'Alexa sous le microscope et ont constaté que 161 de ces 500 sites utilisent Google Analytics, ce qui représente 32,2%.

Rappelons que Google Analytics a été publié en Novembre 2005, mais la première tempête d'inscriptions Google a forcé ce dernier à limiter les inscriptions jusqu'au mois d'août de 2006, lorsque le service est redevenu généralement disponible.

Avant que Google achete Urchin (Google Analytics est basé sur), il était juste un autre paquet statistique sur le marché. Google a pris essentiellement un service commercial, et il l'a rendu gratuit, ce qui lui donne un avantage concurrentiel important. Pourquoi payer pour les autres, des services similaires lorsque vous pouvez utiliser Google Analytics gratuitement?

Une grande partie de cet avantage concurrentiel, et probablement aussi contribué par sa forte image de marque, Google est venu à dominer le marché statistiques des sites web en très peu de temps.

Même si les statistiques sont actuellement un marché secondaire pour Google, la libre disponibilité de Google Analytics doit avoir eu un effet profond sur les concurrents et les produits commerciaux des autres entreprises qui ne peuvent pas se permettre d'offrir leurs services gratuitement.

Francite pour effectuer une recherche multiple

à 11:31 Publié par -

Francité est un moteur qui affiche pour une requête les résultats de recherche sur google, Yahoo, MSN et Voila. L'idée est intéressante dans la mesure ou elle nous fais gagner du temps dans la recherche de résultats.

Francité est un moteur qui affiche pour une requête les résultats de recherche sur google, Yahoo, MSN et Voila. L'idée est intéressante dans la mesure ou elle nous fais gagner du temps dans la recherche de résultats.

Le site Fancité perment aussi de faire plusieurs recherche à la fois :

Libellés : francite 0 commentaires

Google et Yahoo vont mieux indexer les animations Flash

mercredi 9 juillet 2008 à 13:44 Publié par -

Suite à sa collaboration avec Adobe, le moteur de recherche Google est en mesure de mieux indexer les contenus texte d’animations Flash.

Jusqu'à présent, l'indexation de sites en Flash était un peu compliquée. Les développeurs devaient créer une version HTML du site s'ils souhaitent voir le contenu de celui ci correctement indexé par les moteurs de recherche.

L'éditeur Adobe aurait fourni à Google et Yahoo quelques petits secrets concernant son lecteur Flash de manière à ce que les algorithmes de ces moteurs puissent naviguer correctement dans des animations Flash. Adobe annonce que le but de cette collaboration est d'améliorer l'indexation des textes et les liens hypertextes contenus dans les animations Flash.

Et, suite à sa collaboration avec l'éditeur, Google vient d'annoncer « avoir développé un nouvel algorithme pour indexer le contenu textuel dans des animations en Flash de toutes sortes, des menus, boutons bannières aux sites web tout en Flash ». En revanche, le texte d'images et de vidéos contenues dans les animations ne sont pas prises en compte.

Comment les moteurs voient-ils votre flash ?

jeudi 3 juillet 2008 à 10:31 Publié par -

Voici un outil qui montre ce que visuellement à partir de votre fichiers Flash ce qui est visible pour les moteurs de recherche et ce qui ne l'est pas. Cet outil est très utile, même si vous avez déjà le Flash Moteur de recherche SDK installé, car il prévoit une vérification de plus de l'exactitude de l'extrait de texte. Cetl'outil pourrait donner des résultats complètement différents de ceux que le SDK produit.

Lien : http://www.se-flash.com/

Libellés : flash, referencement flash, SDK 0 commentaires

Google et le JavaScript

mardi 1 juillet 2008 à 11:24 Publié par -

Actuellement, Google ne rend pas le code javascript sur une page, mais il ya des rumeurs qu'ils sont en train d'élaborer un nouveau robot basé sur Firefox (ils emploient un nombre de membres fondateurs de Mozilla) qui indexe les pages basées sur la façon dont le navigateur les voit, au lieu de la le contenu HTML brut. Cela signifie que le HTML caché par CSS ne pourra être indexé, et les pages qui sont modifiées par le Javascript après leur chargement seront indexés comment ils apparaissent à l'utilisateur. Toutefois, il s'agit de rumeurs et jusqu'à ce qu'il se passe Google va continuer à ignorer le Javascript de votre contenu.

MOD_REWRITE pour votre site web

jeudi 26 juin 2008 à 09:11 Publié par -

L'optimisation d'url d'un site web et facteur important dans la génération de trafic sur un site web.

L'outil SEO en ligne http://www.mod-rewrite-wizard.com/ permet de transformer les urls complexes en url simples et indexables par les outils de recherche.

http://www.mod-rewrite-wizard.com/ propose donc la régle de réécriture ainsi qu'un appercu de l'url sur la quelle vous voulez faire de l'url rewriting.

Le principal défaut lorsqu'on utilise ce type d'outil (plutôt simpliste) est qu'on n'apprend pas la réécriture, et qu'on aura des difficultés lorsqu'on voudra modifier quoi que ce soit !

Les annuaires d'annuaires

mercredi 25 juin 2008 à 09:10 Publié par -

Les annuaires sont un passage quasi-obligé pour quiconque entend développer un site internet en terme de trafic. Aujourd'hui, un nouveau annuaire d'annuaires marque l'actualité de ce secteur des annuaires.

Annuaire-info est sans doute l'un des plus renommés de la catégorie des annuaires des annuaires et il envoie un trafic appréciable aux annuaires en terme de soumissions de sites.

Url : http://www.annuaire-info.com/

QualiSEO est un nouveau annuaire des annuaires qui va sans nul doute donner du fil à recoudre à l'autre annuaire des annuaires Annuaire-info car il permet une recherche d'annuaires par critères, mais il leur attribue également une notation.

Url : http://www.qualiseo.com/

Stratégies pour accroitre la popularité des liens

vendredi 20 juin 2008 à 10:48 Publié par -

Voici quelques stratégies qui sont généralement considérées comme importantes pour accroître la popularité de lien (link popularity):

* Il devrait y avoir des liens de la page d'accueil vers les pages intérieures pour que le moteur de recherche puisse transférer un peu de popularité du lien (link popularity) à ces pages.

* L'ancre texte avec des mots clés doivent être utilisés dans le texte des liens pointant vers les pages dans un site (techniquement, ceci permettera d'améliorer le contexte du lien (link context) et pas la popularité du lien (link popularity) ).

* Obtenir un lien sur d'autres sites Web, en particulier des sites à fort PageRank, peut être l'un des plus puissants outils de promotion de sites. Par conséquent, le webmaster devrait essayer d'obtenir des backlinks sur d'autres sites offrant des informations ou des produits compatibles ou synergiques à son propre site ou sur des sites qui répondent au même public que vise le site du webmaster.

* Les liens à sens unique (sans liens de retour) comptent plus que les liens réciproques.

* Le webmaster doit inscrire son site dans un ou plusieurs des principaux annuaires tels que Yahoo! ou l'Open Directory Project.

* Le webmaster ne devrait faire des liens que vers sites qu'il fait confiance, c'est-à-dire des sites qui n'utilisent pas de techniques de spam.

* Le webmaster ne doit pas participer à des programmes d'échange de lien ou a des link farms, car les moteurs de recherche sanctionnent les sites qui participent à ces programmes.

Pour accroître la popularité de lien, de nombreux webmasters interconnectent plusieurs domaines qu'ils possèdent, mais trés souvent les moteurs de recherche filtrent ces liens, car ils (liens) ne sont pas des votes indépendants pour une page donnée et ne sont créés que dans le but de tromper les moteurs de recherche.

Déclassement Google pour domaine en .info

jeudi 19 juin 2008 à 09:33 Publié par -

Ce week-end Google vient de déclasser de manière généralisée et brutale la majorité des sites utilisant des noms de domaines a extension TLD info.

SeoBook [en] y voit l'accomplissement d'une prophétie de Matt Cutts qui avait déclaré que les domaines en extension .info allaient poser problème puisque par leur faible prix (jusqu'à 99 cts de dollar chez certains registras) il étaient un met de choix pour les sites de spam.

Filtrer tous les domaines en .info juste parce que certains sont l'objet de spam est une mesure trop draconiennes, et je ne pense pas que c'est ce que Google cherche. Il serait beaucoup plus logiques si on filtrait les domaines en .info qui ont été enregistrées moins d'un an et qui n'ont pas un minimum de nombre de backlinks de "de confiance" vers leurs sites.

Ce déclassement a donc affecté la généralité des extensions .info mais aussi les blogs de la plateforme Blogger. Cette baisse de positions temporaire ait révélé que ce type de sites (.info et blogs Blogger) sont tous simplement présumés comme spammeurs et sont peut-être affublés d'un nouveau filtre plus pointilleux.

Baromètre des moteurs de recherche – Mai 2008

lundi 16 juin 2008 à 11:32 Publié par -

Mensuellement le site XitiMonitor affiche le compte rendu de ses observations sur le volume des visites enregistrées par les sites internet audités en tant que trafic moteur, comme à l'accoutumée la première constatation est la main-mise de Google sur les recherches des francophones.

Voici le détail des top 15 moteurs de recherche pour le mois de mai 2008

Avenir du référencement

jeudi 12 juin 2008 à 09:26 Publié par -

Y a-t-il une limite au référencement naturel ?

Théoriquement, il n'y a pas de limite. Par contre, quand la première place est occupée par un site comptant des milliers de liens référents, la concurrence est plus difficile. Bien souvent, l'encyclopédie Wikipedia ou L'Internaute apparaissent en première position. Il s'avère alors très difficile de les contrer, surtout pour des sites mis en ligne récemment qui affichent parfois des pagerank importants. L'intervention humaine d'un expert est alors la clé du succès car chaque paramètre doit être analysé et réajusté minutieusement.

Prestation de référencement internationale ?

Le référencement se pense sur un marché global mais avec un travail local. Nous référençons en anglais, espagnol, mais aussi en arabe et en japonais. En matière de référencement, les langues non-européennes sont un cap difficile pour les clients. C'est alors que la notion de confiance prend toute son ampleur.

Cinq façons d'optimiser votre vidéo pour pour les moteurs de recherche de vidéo

mardi 3 juin 2008 à 09:31 Publié par -

Comme la vidéo Web émerge rapidement, il est impératif que les moteurs de recherche peuvent trouver vos vidéos aussi facilement qu'ils peuvent trouver votre contenu Web.

Voici cinq mesures pour aider les moteurs de recherche vidéo trouver vos clips:

1) Créer des métadonnées de qualité pour chaque vidéo que vous affichez. La vidéo-moteurs de recherche utilisent les métadonnées pour indexer, catégoriser et classer les contenus vidéo.

Les métadonnées les plus importantes sont les suivants:

- Title décrire avec précision votre vidéo en 40 caractères ou moins, en utilisant les majiscules et des lettres minuscules pour optimiser la lisibilité.

- Description expliquer exactement ce que les utilisateurs verront, en mettant l'accent sur les mots clés que les gens peuvent taper lors d'une recherche.

- Categories, tags ou keywords spécifier tous les termes pertinents que les utilisateurs pourront rechercher.

- Image inclure un descriptif sous forme de thumbnail idéalement 60-par-60, 80-par-80 ou 100-par-100 pixels.

- Publish date en général le jour où vous avez fait la publication.

- Link préciser et indiquer l'URL où réside la vidéo.

2) Inscrivez votre site dans les moteurs de recherche vidéo. Si vous créer de bonnes métadonnées, tout moteur de recherche vidéo de valeur indexera le contenu de votre contenu. Toutefois, vous pouvez accélérer les choses grâce à l'enregistrement dans des moteurs de recherche de vidéo.

3) Créer un fil RSS. RSS est la meilleure façon pour la plupart des moteurs de recherche vidéo pour indexer et mettre à jour votre contenu vidéo.

Les médias format RSS utilise des champs pour catégoriser le contenu, pour assurer de la qualité des métadonnées. Lorsque les moteurs de recherche vidéo ont accès à vos flux RSS, ils indexeront instantanément les nouvelles vidéo que vous ajoutez.

4) Avoir une solide bibliothèque de contenu vidéo par opposition à un site qui contient peu de clip, est une des façons qui peut faire de votre site un fournisseur sérieux de contenu vidéo qui figurera en bonnes positions dans les résultats de recherche.

5) Poster plusieurs clips vidéo avec des contenus similaires. Si vous envoyez plus d'une vidéo sur un sujet similaire, les moteurs de recherche vidéo exerceront un effet de levier sur les autres contenus et proposeront des recommandations (liens) du type "plus comme ceci" ou "voir d'autres vidéo du meme théme".

Cela contribuera à faire grimper votre audience et d'attirer encore plus de trafic.

Search

Labels

- annuaire.info (1)

- anuaire des annuaires (1)

- avanir du référencement (1)

- backlinks (2)

- barometre moteur recherche (1)

- blogger (1)

- chute position google (3)

- declassement google info (1)

- flash (1)

- francite (1)

- GAudi (1)

- google (1)

- google audio (1)

- Google Audio Indexing (1)

- gwt (1)

- indexation annimation flash (1)

- indexation flash (1)

- indexation vidéo (1)

- info tld (1)

- javascript (1)

- liens externes (2)

- link building (1)

- link context (1)

- link popularity (1)

- linkbait (1)

- linking (1)

- métadonnés vidéo (1)

- moteurs de recherche flash (1)

- moteurs de recherche vidéo (3)

- optimisation vidéo (1)

- optimiser proéminence (1)

- page rank (1)

- proéminence google (1)

- proéminence mot cle (1)

- qualiseo (1)

- référement flash (1)

- referencement flash (1)

- référencement internationnal (1)

- référencement javascript google (1)

- référencement video (2)

- SDK (1)

- Site Grader (1)

- site vidéo (1)

- soumission annuaire (1)

- stratégie liens (2)

- video (1)

- webmasters (1)

- widgetbait (1)

- xiti (1)

Meta

Blog Archive

-

▼

2008

(18)

-

►

juillet

(7)

- Netlinking : Bon lien et techniques de linkbait

- Explication de l'effet Google “Sandbox”

- Google Analytics installé sur 1/3 des 500 plus gro...

- Francite pour effectuer une recherche multiple

- Google et Yahoo vont mieux indexer les animations ...

- Comment les moteurs voient-ils votre flash ?

- Google et le JavaScript

-

►

juillet

(7)